Les modèles

La situation climatique à venir va très probablement être totalement inédite depuis que l’homme a démarré son existence terrestre. Comme il est alors impossible de se tourner vers le passé récent pour avoir une idée de ce qui peut se passer plus tard, les seuls outils dont la communauté scientifique dispose pour tenter de savoir ce qui peut se passer à l’avenir sont des modèles climatiques.

Un modèle climatique n’est rien d’autre (nos amis scientifiques trouveront peut-être que ce n’est déjà pas si mal!) qu’un logiciel très complexe, dont le but est de reproduire aussi fidèlement que possible le comportement du climat terrestre. Il s’agit donc d’un gros programme pour ordinateur, construit de la manière suivante :

- les scientifiques compétents sélectionnent, au sein du système climatique planétaire, et chacun pour la partie qui le concerne, quelques paramètres qui sont considérés comme suffisants pour caractériser le système – ou le sous-système – dans son ensemble de manière satisfaisante pour la question posée (qui est celle de l’évolution de long terme du climat), par exemple la température annuelle moyenne et sa répartition par grande zone, les précipitations saisonnières par grandes zones, la couverture végétale avec le contenu en carbone de chaque type de couverture, etc.

- on exprime les relations d’un compartiment à un autre par des lois physiques (par exemple on exprime de manière explicite les fonctions qui permettent de passer de la température de surface à l’évaporation, ou encore les équations de la physique auxquelles l’atmosphère doit obéir en permanence, comme la conservation de l’énergie),

- à ce moment intervient la modélisation informatique proprement dite, c’est à dire que l’on représente, par des lignes de code informatique, les relations de cause à effet et les lois de la physique mentionnées ci-dessus,

- comme on ne peut pas décrire ce qui se passe absolument partout (cela demanderait de traiter un nombre infini de points, et aucun ordinateur n’aime beaucoup l’infini), on fait un maillage: on recouvre notre planète d’un filet imaginaire dont la maille (comme pour un filet de pêche, la maille est la distance qui sépare deux fils) mesure de l’ordre de quelques centaines de km de côté (cela dépend des modèles et de l’époque),

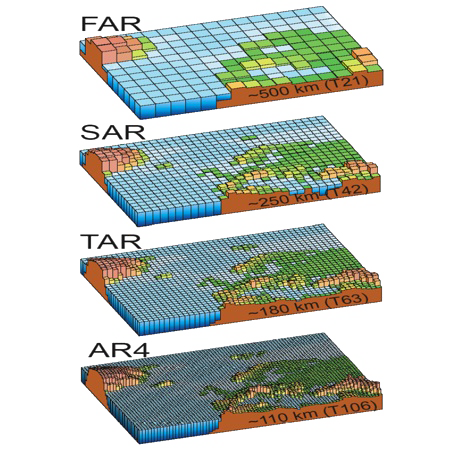

Evolution de la résolution (ou du maillage, c’est pareil) des modèles climatiques globaux au cours du temps.

Avant le premier rapport d’évaluation du GIEC (FAR pour First Assessment Report), c’est-à-dire dans la décennie 1980, la taille de la maille était typiquement de 500 km de côté. A cette époque, la France ne comptait que pour 4 mailles dans un modèle ! C’était l’ordre de grandeur dans tous les modèles globaux ; certains modèles dits régionaux utilisaient des mailles plus petites – de l’ordre de 50 km – au-dessus d’une région particulière mais alors les mailles pour le reste du monde pouvaient mesurer jusqu’à 1000 km de côté.

Au moment du 2è rapport d’évaluation (SAR pour Second Assessment Report ; 1995) la taille de la maille avait été divisée par 2, et 10 ans plus tard (au moment de l’AR4, pour 4th Assessment Report, publié en 2007) elle a encore été divisée par 2 par rapport à la décennie 1980.

Source GIEC, 2007

- comme la planète est un système en 3 dimensions, le monde n’est pas découpé en petits rectangles, mais plutôt en « boîtes à chaussures », avec quelques dizaines de niveaux de « boîtes » le long de la verticale,

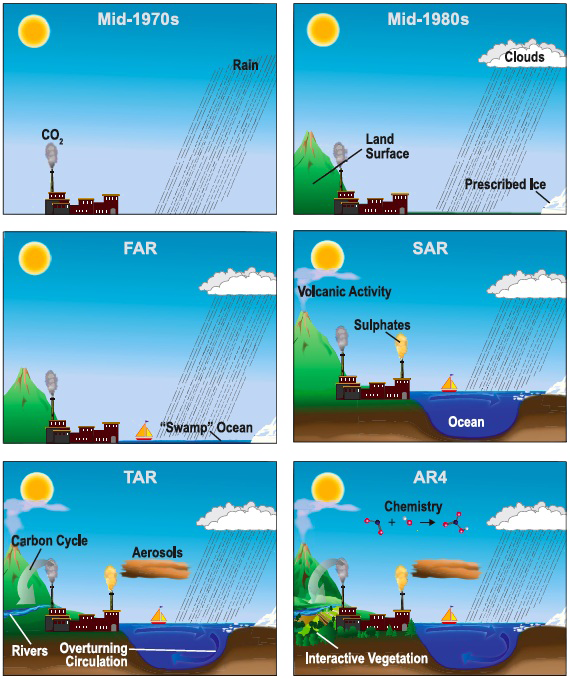

Schéma d’ensemble d’un modèle particulier.

Les intitulés (en Anglais, hélas !) indiquent les éléments et interactions pris en compte dans le modèle.

Source: Hadley Centre.

- à chaque « noeud » de ce maillage en trois dimensions (c’est à dire aux sommets de chaque boîte à chaussures), ou au sein de chaque boîte (cela dépend du paramètre considéré), on fixe les conditions de départ en indiquant les valeurs initiales des différents paramètres avec lesquels l’ordinateur va travailler : si on a affaire à une terre émergée ou à de l’eau, éventuellement quel type de végétation l’occupe, quelle est la température moyenne de départ, la pression, l’humidité, la salinité pour l’eau de mer, la couverture nuageuse, le vent, et plus généralement on initialise tous les paramètres utilisés,

- puis on fait « tourner le modèle », c’est à dire que l’ordinateur se lance et calcule, sur la base des règles qui lui ont été fournies et des valeurs intiales, comment évoluent les paramètres à chaque « nœud » du filet – ou au sein de chaque « boîte » – à intervalles de temps réguliers (en fonction de la puissance informatique dont on dispose, ce sera tous les mois ou toutes les demi-heures !).

L’un des avantages de ces modèles est qu’ils peuvent facilement permettre une comparaison « virtuelle » de deux évolutions du monde (ce qui est impossible dans la réalité, puisque l’histoire ne s’écrit qu’une fois). Il est ainsi possible de spéculer sur ce qui se passe « si » (« si » les hommes émettent des gaz à effet de serre, certes, mais les mêmes modèles servent aussi à reconstituer les climats de la préhistoire ou même à comprendre ce qui se passe sur Mars !). Pour prendre en compte une perturbation humaine qui évolue au cours du temps, par exemple l’augmentation de la teneur en gaz à effet de serre, il suffit de rajouter une équation dans la liste, ou d’imposer une valeur donnée à un paramètre donné.

La modélisation est une discipline qui ne date pas d’hier : les premiers modèles – purement atmosphériques – datent des années 60 (le premier modèle atmosphérique date même de 1950, et a été testé sur le premier ordinateur existant, l’ENIAC). Ce qui a permis un essor rapide de la discipline est plus l’augmentation de la puissance informatique disponible (et l’avènement des satellites, qui ont fourni pléthore de données d’observation qui ont pu être confrontées aux sorties de modélisation) que des percées majeures en physique, physique qui était déjà assez bien connue il y a quelques dizaines d’années (avec comme conséquence que les premières « alertes » sur le réchauffement climatique datent de la fin des années 1960).

Par exemple, le temps de calcul pour simuler un mois d’évolution a été divisé par plus de 100 entre 1980 et nos jours !

Plus la puissance informatique augmente, et plus on peut utiliser des mailles de petite taille. Plus on travaille sur des périodes courtes, et plus on peut aussi diminuer la maille (ce qui augmente la précision des prévisions) : les météorologues, qui ne s’intéressent pas au climat qu’il y aura dans quelques siècles, mais à celui qu’il y aura demain ou dans 3 jours, travaillent sur des modèles atmosphériques identiques à la partie « atmosphère » des modèles de climat globaux, mais avec des mailles de quelques kilomètres de côté seulement.

Désignation des modèles

Selon la manière dont ils sont construits et ce qu’il prennent en compte, les modèles sont désignés avec des sigles différents. En voici quelques uns :

- GCM signifie « Global Circulation Model », et donc en Français « Modèle de Circulation Globale ». Il s’agit d’un modèle global, à larges mailles, pour donner des tendances de long terme sur de larges zones.

- AGCM signifie « Atmospheric Global Circulation Model ». Il s’agit d’une catégorie particulière de GCM, qui ne prennent en compte que l’atmosphère. Cela ne donne des prédictions valables que tant que les autres composantes (sols, océans, glaces) ne bougent pas, et en pratique il s’agit des modèles utilisés pour les prévisions météo.

- AOGCM signifie « Atmospheric Oceanic Global Circulation Model ». Il s’agit d’une autre catégorie de GCM, qui prennent en compte l’atmosphère et l’océan. On voit parfois aussi « Atmospheric Oceanic Global Coupled Model », car dans ces modèles non seulement l’océan est pris en compte, mais aussi les interactions entre l’océan et l’atmosphère. Ce sont ces modèles qui sont utilisés en climatologie.

Il arrive enfin que la lettre R s’intercale quelque part à la place du G : il s’agit alors de modèles régionaux.

Combien de modèles ?

Il existe actuellement une quinzaine de modèles globaux de par le monde, développés par autant d’équipes pluridisciplinaires (un grand pays en a rarement plus de 2 ou 3), qui regroupent environ 2.000 scientifiques de disciplines variées . Toutefois le nombre total de scientifiques de disciplines différentes qui concourent à la construction ou à l’alimentation des modèles est bien supérieur, au moins d’un facteur 10 : pour « savoir quoi mettre » dans ces modèles il faut faire appel à des travaux déjà effectués par des physiciens, des chimistes, des biologistes, des géologues, des océanographes, des aérologues, des glaciologues, des énergéticiens, des démographes…

En France, l’un des pôles de modélisation et d’étude du climat est l’Institut Pierre Simon Laplace (IPSL), rassemblant :

- le Laboratoire de Météorologie Dynamique du CNRS (unité commune à l’Ecole normale, l’Ecole Polytechnique, et l’Université de Paris VI – Jussieu)

- le Laboratoire des Sciences du Climat et de l’Environnement (unité mixte CEA – CNRS).

- le Laboratoire d’Océanographie Dynamique et de Climatologie (unité mixte IRD – CNRS – Jussieu).

- le Laboratoire Atmosphères, Milieux, Observations Spatiales (unité mixte CNRS – Jussieu – Université de Versailles-Saint Quentin).

- le Laboratoire de Physique et Chimie Marines

Que prennent-ils en compte?

Les lois de la physique restent bien entendu les mêmes partout et tout le temps, mais ces modèles sont quand même assez différents les uns des autres : les uns prennent en compte les effets des nuages comme ceci, les autres comme cela, les uns prennent en compte certains phénomènes de la biosphère (la biosphère est l’ensemble des êtres vivants), les autres pas, etc. Ce qui différencie le plus les modèles les uns des autres, cependant, est surtout la date à laquelle ils ont été terminés.

Evolution du degré de complexité des modèles depuis leurs débuts.

Dans la décennie 1970, les modèles étaient purement atmosphériques, avec prise en compte des précipitations et de la composition de l’atmosphère. Dans les années 1980 on a vu arriver l’occupation de la surface, les nuages, et la glace de mer (non couplée). Au moment du premier rapport d’évaluation du GIEC (FAR pour First Assessment Report), l’océan a été rajouté, mais sans représentation de la circulation à grande échelle.

Au moment du 2è rapport d’évaluation (SAR pour Second Assessment Report ; 1995) les modèles ont « accueilli » les aérosols, le volcanisme et la circulation horizontale de l’océan. Au moment du 3è rapport d’évaluation (TAR pour Third Assessment Report ; 2001) ces outils représentaient aussi la circulation océanique profonde, début du cycle du carbone, les rivières. Enfin les modèles utilisés pour l’AR4 (pour 4th Assessment Report, publié en 2007) comprennent pour certains la chimie atmosphérique (c’est-à-dire les processus qui permettent de représenter l’augmentation – ou la diminution – d’une espèce chimique A dans l’atmosphère à partir de la variation d’espèces B + C), et une végétation réagissant de manière dynamique aux conditions climatiques régionales.

Ce qui est remarquable, dans tout cela, est que cette complexification progressive des outils utilisés n’a pas invalidé les conclusions des modèles des années 1970, à savoir que nos émissions allaient modifier le climat, en augmentant notamment la température moyenne de quelques degrés si nous doublons la concentration du CO2 en un siècle.

Source GIEC, 2007 (4è rapport d’évaluation).

Si nous regardons un peu plus dans le détail, voici les principaux items pris en compte dans les modèles utilisés aujourd’hui. Attention ! « Pris en compte » ne veut pas dire que tout est connu sur le point considéré, mais simplement que « on en parle » dans le modèle :

- les échanges d’énergie, en particulier sous forme de rayonnement électromagnétique, entre la Terre, l’océan, l’atmosphère et l’espace (tous les modèles).

- les transferts radiatifs dans l’atmosphère, c’est à dire la manière dont le rayonnement solaire et celui émis par la Terre traversent l’atmosphère ou sont absorbés par les divers gaz à effet de serre contenus dans cette dernière,

Comme on l’a vu, il n’y a pas un seul mais plusieurs gaz à effet de serre. Ces gaz ne sont pas toujours pris en compte de manière indépendante dans les modèles : on commence par faire la « somme » des différents gaz émis, en les pondérant par leurs pouvoirs de réchauffement respectifs, et c’est cette « somme » que l’on utilise pour représenter les émissions de tous les gaz à effet de serre.

Une telle simplification, si elle est appliquée, empêche d’étudier facilement par les résultats de la modélisation les effets d’un début de réchauffement sur les émissions « naturelles » de gaz à effet de serre pris un par un. C’est notamment le cas pour le méthane, dont la vitesse d’élimination dans l’atmosphère dépend significativement de sa concentration.

- la circulation de l’air dans l’atmosphère (tous les modèles), et donc les transports d’eau qui y sont associés,

- la circulation océanique (tous les modèles), et les interactions entre l’océan et l’atmosphère,

- la formation et la fonte de la glace de mer (tous les modèles),

- les nuages (tous les modèles), mais une modélisation correcte des nuages reste un des points où la marge de progression est très importante,

- les échanges de carbone entre l’atmosphère et la planète (tous les modèles, mais avec des degrés de sophistication différents), et depuis peu certaines rétroactions du réchauffement sur les émissions « naturelles » de gaz à effet de serre, et notamment le comportement de la végétation (pas tous, et avec des degrés de sophistications différents).

Quelles sont leurs faiblesses?

Les trois grandes sources d’incertitude des modèles sont les suivantes :

- Tout d’abord notre système atmosphérique n’est pas entièrement prévisible. C’est bien pour cela qu’il arrive que la météo – qui travaille avec les mêmes équations de la physique, même si leurs modèles sont essentiellement atmosphériques – se trompe, même si, statistiquement, elle a souvent raison (mais on entend surtout parler des fois où elle se trompe, ce qui induit un effet de déformation : il ne faut pas que l’arbre masque la forêt !). Cela entache d’incertitude les transferts d’énergie vers l’espace (et donc la température moyenne de la planète), la répartition régionale du changement climatique, etc.

- Ensuite il y a d’inévitables simplifications lorsque l’on construit un modèle. Il est cependant légitime et courant de procéder de la sorte : le simple fait que l’on ait fait une simplification n’est pas nécessairement une source d’erreur. Par exemple, le plan de l’architecte ne reproduit pas tous les détails du futur bâtiment mais seulement les « choses les plus importantes » : pour autant, se fera-t-on une mauvaise idée de la facilité avec laquelle on circulera dans le bâtiment ?

- ils ne représenteront toujours qu’une partie du système (mais heureusement cela suffit à souligner l’existence de risques importants). Parmi les éléments qui doivent être mieux pris en compte, on peut citer:

- les nuages (car il s’agit d’objets de petite taille relativement à la taille de la maille, donc que l’on est donc obligé de traiter de manière approchée),

- puits et sources du carbone océanique et continental, et notamment influence de la biosphère, avec une limite qui est que la biosphère est toujours dépendante de conditions locales et que la modification de ces dernières est plus incertaine que la modification des conditions « globales »,

- l’évaporation continentale, qui fait aussi intervenir des processus de petite échelle (c’est à dire de « petite taille » par rapport à la taille de la maille),

- la circulation océanique profonde (qu’il est difficile de mesurer, donc pour laquelle il est difficile de comparer ce que dit le modèle avec la réalité),

- le cycle du méthane (le gaz du « pourrissement »), et du protoxyde d’azote, où les sources naturelles ne sont pas quantifiées avec précision,

- la prise en compte de l’augmentation de l’ozone troposphérique (celui qui est près du sol), car cela dépend d’une chimie atmosphérique complexe,

- le rôle des aérosols organiques ou minéraux (les poussières).

Mais il ne faudrait pas déduire du fait qu’il reste des zones d’ombres que l’on peut ignorer les résultats, ce qui serait jeter le bébé avec l’eau du bain ! En outre, ces outils sont en perpétuelle évolution, et donc en perpétuelle amélioration.

Premières conclusions des modèles

Un point essentiel est que, même si ils sont construits de manière différente, même si les résultats chiffrés auxquels ils parviennent ne sont pas rigoureusement identiques, tous ces modèles aboutissent à des conclusions de même nature : l’homme modifie le climat dans le sens d’un réchauffement global de la planète. En outre ces modèles indiquent aussi que plus les émissions de gaz à effet de serre sont élevées, et plus le système réagit de manière forte.

La température moyenne de la planète va augmenter. Selon le scénario d’émission pris en compte, il est question de 1°C à 6 °C entre 2000 et 2100.

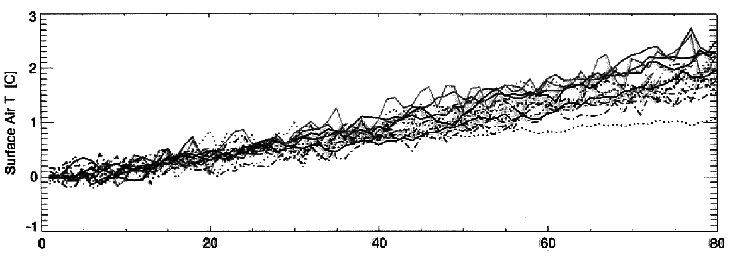

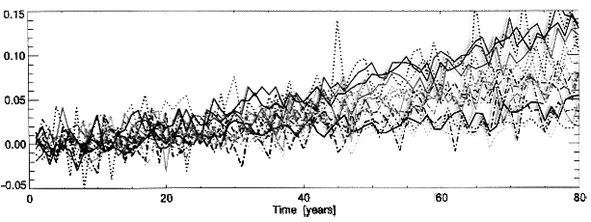

Augmentation de température moyenne de l’air au niveau du sol (ce que l’on appelle « la température moyenne de la Terre ») en fonction des années (le 0 correspond à l’an 2000), à raison d’une courbe par modèle.

L’axe vertical est gradué en degrés.

Tous les modèles ont été alimentés avec la même hypothèse : une concentration en CO2 qui augmente de 1% par an (ce qui est à peu près le rythme d’évolution au début du 21è siècle).

Sources : PCMDI/IPSL

- Les échanges d’eau entre la surface et l’atmosphère vont augmenter (cf. schéma ci-dessous). Cela peut s’expliquer assez simplement (même sans modèle!) : un air globalement plus chaud peut contenir plus de vapeur d’eau, et donc l’évaporation augmentera. Comme la vapeur d’eau ne s’accumule pas dans l’atmosphère, tout ce qui monte doit redescendre, et donc une évaporation accrue engendrera globalement plus de précipitations (et du reste pendant les périodes glaciaires, durant lesquelles le climat est plus froid, il fait beaucoup plus sec). Cela signifiera qu’il va pleuvoir plus souvent, ou…plus fort (avec une augmentation du risque d’inondations dans ce dernier cas)

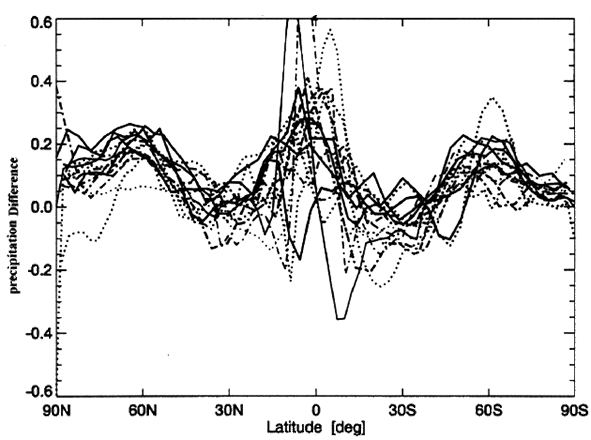

Evolution des précipitations moyennes annuelles par rapport à l’an 2000 (0 des ordonnées) à raison d’une courbe par modèle.

L’axe vertical est gradué en millimètres d’eau par jour.

Tous les modèles partent de la même hypothèse d’une concentration en CO2 qui augmente de 1% par an.

Lorsqu’une courbe franchit la valeur 0,05, par exemple, cela signifie qu’à ce moment là les précipitations moyennes à la surface du globe augmentent de 0,05 mm d’eau par jour, soit un peu plus de 18 mm d’eau par an, soit encore 3,5% des précipitations actuelles (520 mm d’eau par an en moyenne).

Toutefois ce surplus de précipitations ne serait pas réparti de manière égale partout : les modèles prévoient de grandes disparités en fonction de la latitude.

Sources: PCMDI/IPSL

Répartition du surplus (ou du déficit) de précipitations en fonction de la latitude au moment ou la concentration de CO2 dans l’atmosphère aura doublé (entre 2060 et 2080 ans selon les émissions futures), a raison d’une courbe par modèle.

L’axe vertical est gradué en mm d’eau par jour, et donne donc la différence de la moyenne journalière de précipitations (pour la terre entière) entre la situation future de la simulation et aujourd’hui.

On voit par exemple que à la latitude 60° Nord (Nord de l’Ecosse, Sud de la Norvège, où il pleut déjà pas mal, il pleuvrait encore plus (70 mm d’eau par an en plus en moyenne) alors que vers 30°N (Californie, Sahara, Mongolie, bref des endroits peu arrosés) il pleuvrait autant ou plutôt moins, et que vers 30 °S (Afrique du Sud, Australie, Argentine) il pleuvrait plutôt un peu moins.

Sources: PCMDI/IPSL

- Enfin il y aura un réchauffement plus prononcé :

- la nuit (par opposition au jour),

- l’hiver (par opposition à l’été, ce qui n’est pas sans conséquence pour la végétation, voir plus loin),

- aux pôles (par opposition aux moyennes latitudes),

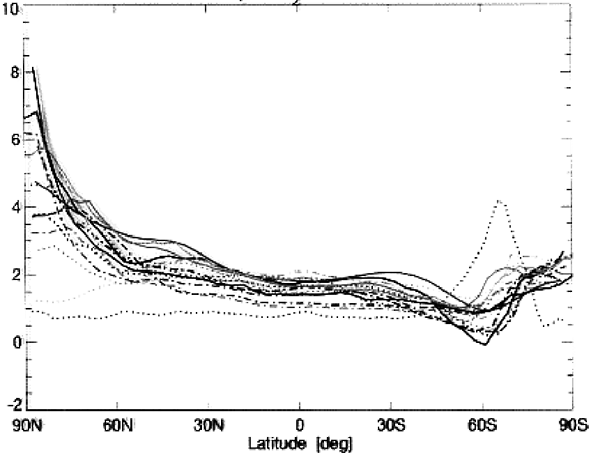

Augmentation de température en fonction de la latitude au moment ou la concentration de CO2 dans l’atmosphère aura doublé (vers 2060 à 2080 ans en « prolongation tendancielle ») à raison d’une courbe par modèle.

On voit que les glaces du Pôle Nord (90° de latitude Nord, à gauche sur la figure) sont les premières concernées : à ce moment là, l’augmentation moyenne de température au Pôle Nord pourrait aller jusqu’à 8° C !

Sources: PCMDI/IPSL

Les 3 différences mentionnées ci-dessus proviennent peuvent être expliquées avec la même raison: l’effet de serre correspond à l’interception du rayonnement terrestre, lequel ne disparaît pas la nuit ou l’hiver. Cet effet est donc proportionnellement plus important partout où il n’y a pas de soleil. En effet, en l’absence de notre astre du jour, l’effet direct du chauffage solaire n’existe plus (ou est réduit en hiver), pendant que l’effet indirect de chauffage du sol provenant de l’effet de serre décroit moins vite. De ce fait l’effet relatif de son augmentation (de l’effet de serre) est plus sensible quand il n’y a pas de soleil (en hiver et la nuit). Un autre processus va dans le même sens : quand il n’y a pas de soleil, l’air est plus froid, donc plus sec, et l’effet de serre « naturel » du à la vapeur d’eau est plus faible. En conséquence, l’effet de serre additionnel du à l’augmentation du CO2 dans l’air (lequel est réparti de manière homogène et indépendant de la température) est proportionnellement plus élevé là où la température est basse (à l’Equateur, où l’air est déjà saturé en vapeur d’eau, l’augmentation de la concentration en CO2 a un effet bien plus faible sur l’effet de serre qu’aux pôles). Cela explique aussi pour partie de l’augmentation de température plus marquée près des pôles.

sur les continents (par opposition aux océans), car l’inertie thermique des grandes masses d’eau est très supérieure à celle du sol; un facteur 1,5 à 2 étant parfaitement possible entre l’augmentation globale et celle au-dessus des continents de l’hémisphère Nord. Cela signifie que pour 3 °C d’augmentation de la température moyenne, qui correspond à un scénario d’émission qui reste compatible avec les ressources fossiles inventoriées, nous pourrions avoir près de 5° C d’augmentation moyenne au-dessus des continents. Et que dire quand on sait que la température moyenne pourrait monter de 8 à 9 °C d’ici à 2 siècles!