Article publié dans Journal de Physique – proceedings, volume 121, Janvier 2005

Résumé

Les scénarios d’émission de l’IPCC ont déjà été été critiqués à plusieurs reprises dans le passé pour leur « manque de réalisme » en ce qui concerne la consommation cumulée de combustibles fossiles pour le 21è siècle qu’ils supposent, ainsi que pour le rythme de consommation de ces combustibles pendant le même siècle.

Le présent article examine rapidement dans quelle mesure ces scénarios sont compatibles avec les données publiées par ailleurs par les géologues en ce qui concerne les combustibles fossiles. Par ailleurs, ces scénarios n’incluent pas une évolution où la stabilisation de la concentration atmosphérique en CO2 deviendrait un objectif explicite de l’humanité toute entière.

La deuxième partie de cet article fournit quelques éléments concernant la consommation matérielle qu’un tel objectif impliquerait si plusieurs milliards d’hommes se trouvent toujours sur Terre.

Introduction

Quand quelqu’un cherche à estimer ce que pourrait être l’avenir, même si l’avenir est incertain, il est assez fréquent qu’il procède en tentant de définir le haut et le bas de la fourchette des évolutions possibles à une échéance donnée. En ce qui concerne le changement climatique, il est désormais assez bien connu, et pas seulement au sein de la communauté scientifique concernée, que le rapport d’évaluation du GIEC en 2001 a conclu que la température moyenne de la planète pourrait s’élever de 1,4 à 5,8 °C en 2100 par rapport à ce qu’elle était en 1990 [1]. Dans quelle mesure avons-nous ici le haut et le bas de la fourchette des conséquences possibles de l’évolution que notre espèce a mis en route ?

Comme le lecteur le sait probablement, ce résultat quantitatif concernant l’élévation de température au cours du 21e siècle est obtenu en forçant un ensemble de 15 modèles de climat avec des concentrations atmosphériques croissantes de gaz à effet de serre. Beaucoup de gens, dans le grand public, supposent qu’une seule augmentation de la concentration atmosphérique en gaz à effet de serre est utilisée pour toutes les simulations, que l’écart très important entre le haut et le bas de la fourchette reflète seulement les caractéristiques très différentes des divers modèles utilisés, et donc que le degré de confiance qu’il convient d’attribuer aux outils qui permettent de prédire le climat futur est très bas. Les personnes informées savent que cela n’est pas le cas : l’hypothèse concernant l’augmentation des gaz à effet de serre dans l’atmosphère n’est pas la même pour la simulation qui débouche sur 5,8°C de hausse et celle qui débouche sur 1,4 °C.

Pour la majorité des simulations climatiques, et en particulier celles analysées dans le rapport d’évaluation du GIEC, les physiciens utilisent généralement un des 40 scénarios d’émission qui ont été conçus comme une base de travail à cette fin, et qui sont décrits dans un rapport spécial du GIEC [2]. Ces scénarios d’émission, regroupés en 4 familles, permettent alors de modéliser une évolution de la quantité de gaz à effet de serre dans l’atmosphère, ce qui requiert aussi des hypothèses en ce qui concerne la vitesse à laquelle les gaz à effet de serre sont retirés de l’atmosphère.

Bien que ce ne soient que de simples hypothèses pour les modélisateurs du climat, les scénarios d’émission jouent un rôle crucial dans l’élévation de température obtenue après un siècle de simulation climatique, et le grand public – cela commence en fait avec la presse généraliste – a du mal à comprendre que les élévations de température du 21è siècle contenues dans le rapport du GIEC ne sont pas des prévisions au vrai sens du terme, mais la réponse d’un jeu donné de modèles climatiques à un ensemble donné d’augmentations des gaz à effet de serre dans l’atmosphère. Pour une même hypothèse concernant l’augmentation des gaz à effet de serre dans l’atmosphère, la différence entre le haut et le bas de la fourchette de températures en 2100 n’est plus de 4,4 °C (différence entre 1,4 et 5,8), mais plutôt comprise entre 1,5 °C et 2 °C. De ce fait une discussion sur le fait que l’élévation de température pourrait se situer plutôt dans le haut ou plutôt dans le bas de la fourchette de 1,4 à 5,8 °C doit séparer deux aspects :

- une discussion sur la sensibilité des modèles climatiques, qui porte sur une différence de 1,5 à 2 °C en 2100 pour un scénario donné. Cette discussion est équivalente, d’une certaine manière, à celle qui consiste à chercher à attribuer un niveau de confiance donné a chaque modèle actuellement utilisé. Comme ils sont tous aptes à reproduire de manière globalement satisfaisante le climat actuel [1], et que l’auteur n’a pas de compétences particulières en ce qui concerne la simulation climatique, nous ne proposerons aucune conclusion sur ce point,

- une discussion sur le fait que le haut et le bas de la fourchette des scénarios d’émission reflète fidèlement le haut et le bas de la fourchette des évolutions possibles de la démographie et du « mode de vie », à la fois dans les pays en développement et dans les pays développés.

Ce papier a juste la modeste ambition de suggérer quelques éléments se rapportant au second item, et plus précisément :

- si les scénarios les plus « intensifs en carbone » sont compatibles avec ce que nous connaissons du monde par ailleurs, et en particulier si ils sont compatibles avec les données publiées par les experts de l’énergie en ce qui concerne la quantité maximale récupérable de combustibles fossiles,

- si nous baissons les émissions jusqu’à ce que les concentrations de gaz à effet de serre dans l’atmosphère cessent d’augmenter, pouvons nous en déduire quelques implications en ce qui concerne notre vie quotidienne ?

1 – Les scénarios d’émission : jusqu’où peuvent-ils raisonnablement aller ?

1.1 Population

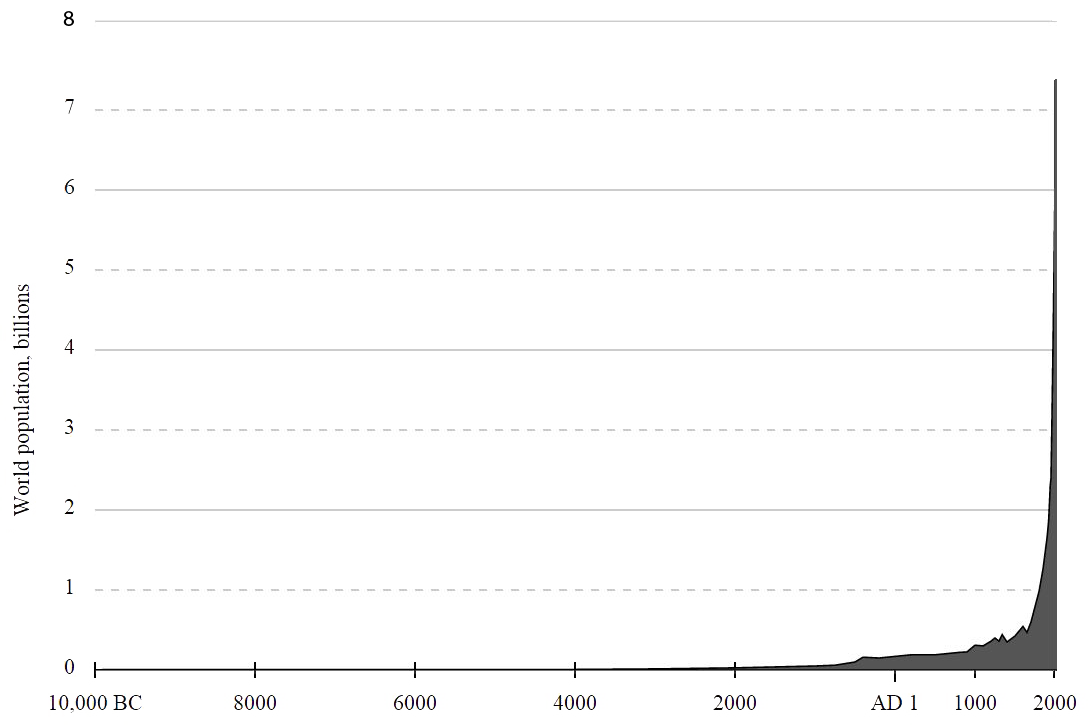

En 2000, la population du globe se montait à 6 milliards d’être humains. Il s’agit assurément là d’un nombre bien plus important que ce que notre planète a connu durant les millions d’années qui se sont écoulées depuis l’apparition de notre espèce, et cela est toujours considérablement supérieur à ce que la population mondiale a représenté durant les siècles et millénaires qui ont précédé 1900 (graphique ci-dessous) : nous n’étions que quelques millions d’hommes quand l’agriculture a fait son apparition ; cela n’a pris que 13 ans (de 1987 à 2000) de rajouter un milliard d’individus supplémentaires à la population mondiale alors qu’il a fallu 10.000 ans pour passer de quelques millions de personnes à 1 milliard.

Evolution de la population mondiale depuis le néolithique.

Il n’y a absolument aucun doute que nous avons vécu une accélération brutale au cours des époques récentes, et il est légitime de se demander si la prolongation de cette évolution peut être « soutenable » durant le siècle à venir, parce que des rétroactions négatives de toute sorte vont en s’amplifiant avec la taille de la population. Comme la taille de la population actuelle est sans précédent, il n’est pas possible de se tourner vers le passé pour savoir si la terre est capable de supporter pour un siècle de 3 à 9 milliards d’être humains supplémentaires, comme les scénarios d’émission le supposent.

En fait, il n’est même pas possible de savoir si l’environnement terrestre pourrait supporter 6 milliards d’être humains pour quelques siècles (ou même un seul), parce que même si la taille de la population restait stable à 6 milliards d’individus, le simple fait que nous recherchions la croissance matérielle perpétuelle met le monde perpétuellement hors d’état d’équilibre, et tant que la situation n’est pas stable il est difficile de proposer une prédiction fiable.

Si nous revenons aux scénarios d’émission, ils s’appuient sur 3 scénarios démographiques.

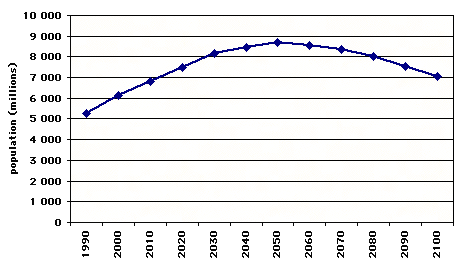

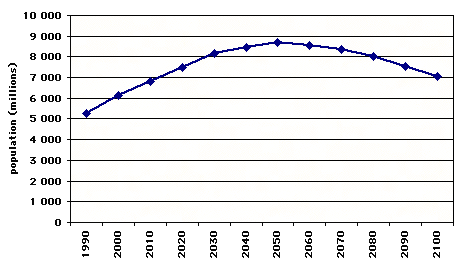

Les familles A1 et B1 supposent que la population croît jusqu’à 9 milliards d’individus en 2050, et décroît jusqu’à 7 milliards à la fin du 21e siècle.

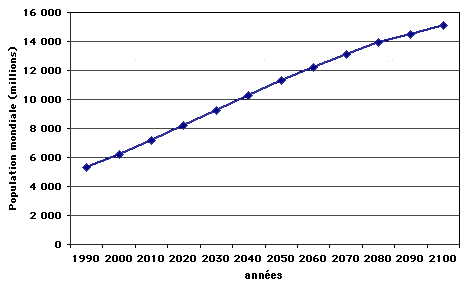

La famille A2 suppose que la population croît jusqu’à 15 milliards d’individus en 2100, et continue à croître ensuite.

Et enfin la famille B2 suppose que la population croît jusqu’à 10 milliards d’individus en 2100, et continue à croître ensuite.

Tous les scénarios supposent donc que la population va rester plus nombreuse – et quelques fois beaucoup plus nombreuse! – que ce qu’elle a été pendant le 20e siècle. Si nous regardons les chiffres d’un peu plus près, la comparaison est la suivante :

Population moyenne au cours du 20e siecle : 3 milliards d’individus

Population moyenne au cours du 21e siecle :

- pour les scénarios A1 et B1 : 7,8 milliards d’individus

- pour les scénarios A2 : 10,9 milliards d’individus

- pour les scénarios B2 : 8,9 milliards d’individus

En d’autres termes, tous les scénarios supposent que la terre peut subvenir, pendant au moins un siècle, aux besoins d’une population au moins 2,5 fois plus nombreuse, en moyenne, que ce qu’elle a été pendant le 20e siècle. Sans parler des conséquences en ce qui concerne l’énergie, que nous examinerons plus bas, il est permis de se demander si cela est compatible avec les possibilités concernant la production agricole, l’eau, le bois, les minerais divers, etc, surtout si nous supposons que la consommation par individu va aussi augmenter d’un facteur 2 à 5 dans le même temps. Si le but des scénarios est de proposer une palette complète d’évolutions possibles, sans considérations sur le fait qu’elles soient désirables ou moralement acceptables, on peut se demander pourquoi une décroissance importante de la population – qui ne peut pas être exclue, par exemple comme conséquence d’épidémies majeures – n’a pas été incluse dans l’ensemble.

Un exemple parmi d’autres : le changement climatique étant supposé favoriser la migration vers les pôles de toutes sortes de maladies à vecteur, l’augmentation des inondations qui causent parfois des épidémies importantes, l’augmentation des vagues de chaleur, et l’apparition d’une pression à la baisse sur les récoltes au-delà d’un certain seuil d’élévation de la température, dans quelle mesure est-ce que les évolutions démographiques mentionnées ci-dessus sont compatibles avec les conséquences sanitaires possibles du changement climatique, pour commencer ? Le lecteur notera que de considérer ces scénarios comme improbables n’est pas nécessairement une bonne nouvelle : une décroissance rapide de la population comme conséquence d’une série d’épidémies majeures peut difficilement être qualifiée de vision radieuse. Cela étant, si nous nous limitons au problème du changement climatique, cela peut assurément en changer l’ampleur.

1.2 Combustibles fossiles

Tous les scénarios d’émission supposent une certaine consommation de pétrole, de gaz et de charbon tout au long du 21e siècle. La première question qui vient à l’esprit est bien sûr de savoir si la consommation cumulée de chaque scénario est compatible avec les ressources extractibles restantes. Ce qu’il « reste à extraire » du sol peut porter des noms différents en fonction de la catégorie à laquelle cela appartient :

- Les réserves prouvées correspondent à des ressources physiques connues que les opérateurs déclarent comme extractibles de manière certaine aux conditions techniques et économiques du moment,

- Les réserves additionnelles correspondent à la fraction extractible des découvertes à venir, plus la fraction supplémentaire des ressources connues que les opérateurs ne considèrent pas comme extractible aujourd’hui mais très probablement extractibles dans un avenir plus ou moins lointain, plus la fraction qui sera extractible des réévaluations des ressources physiques déjà découvertes.

L’industrie pétrolière a mis sur pieds un système élaboré pour qualifier et évaluer ces réserves additionnelles, et ces dernières sont subdivisées en 2 sous-catégories : probable et possible, qui correspondent chacune à un niveau de probabilité différent en ce qui concerne la disponibilité future. La comparaison des consommations cumulées pour le 21e siècle avec les seules réserves prouvées déclarées en 2000 est donc de peu d’utilité, dans la mesure où ces réserves prouvées ne correspondent qu’à une partie de ce qui reste à extraire.

Une notion bien plus utile pour notre propos est celle de « réserve ultime ». Pour n’importe quel combustible fossile, les réserves ultimes désignent tout le combustible qui sera (ou pourrait être) extrait du sol du début à la fin de l’exploitation du combustible en question. Les réserves ultimes correspondent donc à la somme de la consommation cumulée jusqu’à présent (qui a assurément été extraite), des réserves prouvées, et des réserves additionnelles. Les réserves ultimes restantes correspondent aux mêmes quantités déduction faite de la consommation cumulée (et donc les réserves ultimes restantes correspondent à la somme des réserves prouvées et des réserves additionnelles, ou encore tout ce qui pourra être extrait dans le futur, proche ou lointain).

L’unité que la majorité des personnes utilisent quand il s’agit de discuter de la consommation future d’énergie, est la tonne équivalent pétrole, ou tep, et ses multiples. 1 tep vaut 42 milliards de joules, en chiffres ronds (ou 11600 kWh), et pour donner deux ordres de grandeur importants :

- en 2000, le monde a consommé en gros 10 Gtep (milliards de tep) d’énergie primaire (dont 1 Gtep d’énergie non commerciale, essentiellement du bois, le reste se composant de pétrole, de gaz, de charbon, d’énergie nucléaire et d’hydroélectricité),

- cette année là, un Européen ou un Japonais a consommé environ 4 tep, pendant qu’un américain a consommé à peu près le double.

Depuis le début de l’ère pétrolière, il y a toujours eu des tentatives pour estimer les réserves ultimes pour le monde entier, en dépit des difficultés liées à ce genre d’exercice. En effet, il n’y a pas de base de données publique, facilement accessible, et analysée de manière croisée, qui donnerait une vue exhaustive des ressources pétrolières du monde (les ressources désignent généralement ce qui est contenu dans le sous-sol, et leur importance conditionne à l’évidence la discussion sur les réserves ultimes). En outre, fournir une telle estimation (sur les réserves ultimes) impose de formuler une hypothèse sur le taux d’extraction de la ressource, maintenant et plus tard, et cela repose pour l’essentiel sur des avis d’expert. De ce fait, il existe un certain nombre de publications concernant les réserves ultimes, publiées, à partir des informations auxquelles ils ont accès, par des experts et des opérateurs pétroliers variés.

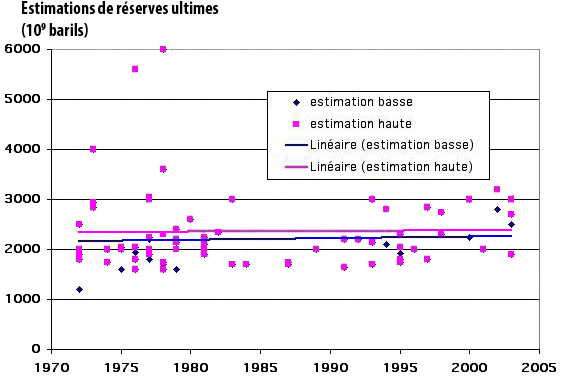

Le graphique ci-dessous synthétise environ 100 publications de cette nature postérieures à 1970 [3].

Estimations publiées depuis 1970 des réserves ultimes, en milliards de barils

(1 tonne = environ 7 barils).

Pour chaque estimation nous avons mentionné le haut et le bas de la fourchette.

Il n’y a pas de tendance nette à la hausse – ou à la baisse – de la valeur médiane des estimations depuis 1970, qui sont stables aux alentours de 2500 milliards de barils, ou 350 Gtep en chiffres ronds (les estimations les plus optimistes datent de juste après 1975 et non après !).

On notera qu’avec le temps l’écart entre les estimations « optimistes » et « pessimistes » a plutôt tendance à se réduire.

Source : [3]

Si nous faisons confiance à ces experts, les réserves ultimes de pétrole conventionnel sont donc limitées à 360 Gtep, desquelles il faut déduire 130 Gtep de pétrole déjà consommé avant 2000, ce qui laisse environ 230 Gtep pour les réserves ultimes restantes cette année-là. Une réévaluation significative de ce montant à l’avenir pourrait venir soit de futures découvertes significatives, soit d’une augmentation significative du taux d’extraction à l’avenir, soit d’une réévaluation future du montant des ressources déjà découvertes. Bien sûr, n’importe lequel de ces événements devrait se produire sans avoir été prévu à ce jour, parce que tous les événements futurs qui sont prévisibles (comme une augmentation probable du taux d’extraction du pétrole conventionnel à cause des nouvelles techniques en développement) sont pris en compte dans le calcul des réserves ultimes.

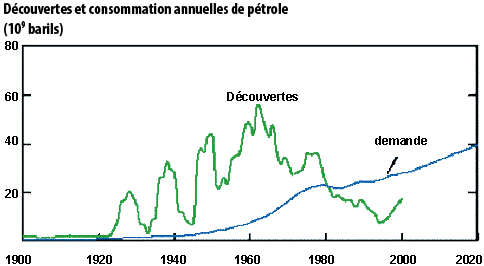

Si nous commençons par examiner les découvertes, la probabilité qu’il en advienne de majeures à l’avenir ne semble pas très probable, au vu du déclin observé depuis 1960, en dépit des divers chocs pétroliers qui ont à chaque fois relancé les efforts de prospection (graphique ci-dessous).

Découvertes annuelles de pétrole conventionnel, en milliards de barils, et consommation annuelle mondiale (ou demande), de produits pétroliers (en milliards de barils aussi).

La courbe de gauche concerne les découvertes de ressources en terre, non la fraction qui sera extraite, qui sera sensiblement inférieure.

Source : Exxon Mobil, 2002

Les autres sources possibles de réévaluation sont d’une portée limitée : le taux d’extraction ne montera jamais jusqu’à 100%, parce qu’un « réservoir » de pétrole n’est pas comme un réservoir d’essence, mais une pierre poreuse imprégnée d’huile, et si les pores sont très petits et l’huile très visqueuse, il y a une « adversité physique » contre laquelle la technologie ne peut pas grand’chose. Par ailleurs, la réévaluation des ressources physiques décroit avec le temps, parce que avec les années il y a de plus en plus d’informations accessibles sur le potentiel ultime des champs déjà en exploitation. De la sorte, on peut discuter d’une possible augmentation de 30% des réserves ultimes, mais qu’elles puissent être multipliées par 2 semble très improbable.

A côté de ce qui s’appelle des « réserves de pétrole conventionnel », c’est-à-dire des réservoirs dans lesquels l’huile est fluide, il y a aussi des ressources non conventionnelles : sables bitumineux, schistes bitumineux, etc, mais le « pétrole » dont il est question en pareil cas est en fait plus proche du charbon ou du bitume en ce qui concerne ses propriétés physiques. Il n’est donc pas possible d’extrapoler le taux d’extraction actuel du pétrole conventionnel (qui est actuellement de l’ordre de 35%) au pétrole non conventionnel, parce qu’il est peu probable que ce pétrole-là soit aussi facile à extraire que le conventionnel. Comme les estimations pour les ressources en terre de pétrole non conventionnel (offshore profond, huiles extra-lourdes, sables bitumineux) se montent actuellement à 600 Gtep [10] [11], un taux d’extraction raisonnable de 20% signifierait un surplus de 100 Gtep aux réserves ultimes de pétrole, nous amenant à un total de 330 Gtep de réserves ultimes restantes, que nous arrondirons à 350 Gtep.

Un premier exercice intéressant est alors de confronter la consommation cumulée de pétrole des divers scénarios à cette valeur (graphique ci-dessous) : seulement quatre scénarios « passent le test » et conduisent à une consommation cumulée de pétrole pour le 21e siècle qui soit inférieure aux réserves ultimes.

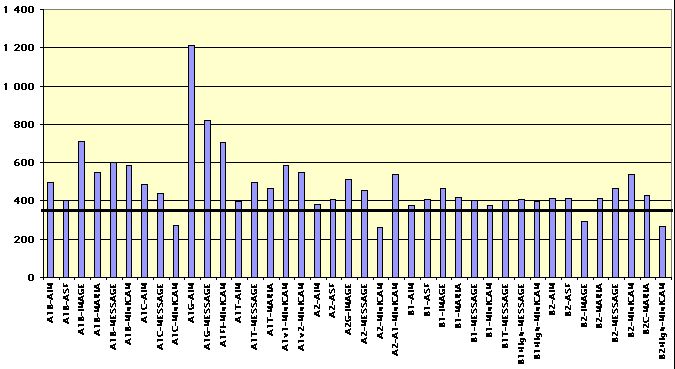

Consommation cumulée de pétrole pour le 21e siècle pour les 40 scénarios du SRES, en Gtep (axe vertical).

Seulement 4 conduisent à une consommation cumulée de pétrole qui soit sous l’estimation médiane des réserves ultimes restantes, c’est-à-dire 350 Gtep (trait noir horizontal).

Source [2]

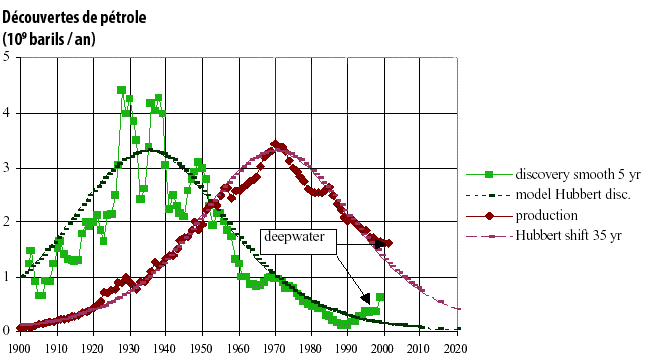

En plus de l’existence d’une limite supérieure pour la consommation cumulée, les géologues ont noté une autre règle que l’extraction de pétrole doit à peu près suivre, qui est une corrélation entre la courbe décrivant les découvertes et celle décrivant la production. En effet, il a été observé sur la majorité des bassins pétroliers que la production suit une courbe qui reproduit approximativement la courbe des découvertes avec un décalage constant. Comme dans la majeure partie des régions du monde – et pour le monde dans son ensemble, comme nous l’avons vu plus haut – la courbe représentant les découvertes est plus ou moins en cloche, cela signifie que la production va aussi suivre plus ou moins une courbe en cloche. Un exemple est donné ci-dessous pour la partie continentale des USA (c’est-à-dire en excluant Alsaka et Hawai).

Courbe de gauche avec des carrés verts : courbe des découvertes annuelles aux Etats Unis (hors Alaska et Hawaï), en moyenne glissante sur 5 ans (en milliards de barils découverts par an).

Le rythme des découvertes peut être approximativement modélisé par une gaussienne (appelée « model Hubbert discoveries », parce King Hubbert, un géologue américain, fut le premier à remarquer cela.

Courbe de droite avec losanges rouges (production) : production annuelle aux USA, en milliards de barils. La gaussienne décalée de 35 ans est aussi représentée.

On peut constater qu’elle recouvre presque parfaitement la courbe de la production. En d’autres termes, une bonne approximation de la courbe de production peut être obtenue en décalant d’une durée constante la gaussienne modélisant la courbe des découvertes.

Source : [6]

Une conséquence de cette forme générale de la courbe théorique représentant la production est que, comme elle est symétrique, la production atteint un maximum quand la moitié des réserves ultimes sont extraites (on parle de pic de production). Dit d’une autre manière, la production ne peut guère continuer à croître après que la moitié des réserves ultimes ait été consommée. Cette forme générale de la production a été observée sur de nombreux bassins pétroliers qui sont déjà passés par leur maximum de production [4].

De la sorte, si nous considérons qu’une courbe en cloche est aussi une approximation acceptable pour la production du monde dans son ensemble, alors nous ne pouvons pas avoir, dans un scénario d’émission, une consommation pétrolière qui continue à croître après que la moitié des réserves ultimes mondiales ait été consommée, à peu de choses près. Comme la moitié de l’estimation médiane des réserves ultimes, en incluant le pétrole non conventionnel, représente de l’ordre de 230 Gtep, dont 130 ont déjà été consommés avant 2000, cela signifie qu’aucun scénario ne peut reposer sur une consommation de pétrole toujours croissante après que 100 Gtep supplémentaires aient été consommées à partir de 2000.

Il se trouve que très peu de scénarios satisfont à cette contrainte pour le pétrole si nous calculons la consommation cumulée de pétrole avant le pic de production à partir des tables statistiques de [2] : avec des réserves ultimes restantes de 350 Gtep, seulement 7 (sur 40) sont compatibles ; il faudrait monter les réserves ultimes restantes à 450 Gtep pour que 50% des scénarios satisfassent à cette règle, et à plus de 2500 Gtep – ce qui est de très loin supérieur à tout le pétrole présent dans les réservoirs exploitables, y compris non conventionnels – pour que tous les scénarios sont compatibles avec cette contrainte.

Le même raisonnement peut s’appliquer au gaz et au charbon, avec une différence majeure, qui est que les réserves ultimes pour le gaz et le charbon ont fait l’objet d’évaluations beaucoup moins fréquentes que celles de pétrole : peu de publications donnent des estimations pour les réserves ultimes mondiales pour ces deux combustibles. Une autre différence, due à des raisons géologiques, est que la courbe de production peut très bien ne pas être symétrique pour le gaz, parce qu’une fois que la pression a commencé à décroître (ce qui engendre une baisse de la production), il ne reste pas grand chose dans le réservoir et le déclin est rapide. En outre, pour le gaz, la valeur retenue pour les réserves ultimes dépend en premier lieu des hypothèses faites en ce qui concerne la possibilité de récupérer un jour une fraction des hydrates de méthane qui sont sensés constituer une partie de la couche supérieure des sédiments océaniques.

Aujourd’hui, les données publiées ne permettent ni d’écarter de manière certaine qu’il sera possible de recourir à ces hydrates à l’avenir, ni de prouver que nous trouverons un jour un gisement exploitable dans les fonds marins, sachant que ce n’est pas le cas actuellement. Cela étant, les réserves ultimes s’appuient généralement sur toutes les ressources que nous considérons comme probablement exploitables « un jour », comme conséquence du progrès technique, ou comme conséquence des lois probabilistes appliquées aux gisements de combustibles fossiles (qui permettent d’estimer ce qui « reste à découvrir »). A la lumière de ce qui est publié, il n’y a aucune garantie que nous découvrirons un jour des gisements commercialement exploitables d’hydrates de méthane. En tenir compte dans les réserves ultimes semble donc discutable.

Les réserves prouvées de gaz se montent aujourd’hui à 140 Gtep en gros, et les réserves additionnelles restent inférieures à 150 Gtep pour la majorité des estimations. Pour le gaz non conventionnel (comme le « coal bed methane« ), les réserves prouvées, c’est-à-dire les combustibles qui sont déjà extractibles aux conditions techniques et économiques du moment, sont très basses : quelques Gtep seulement. [5]. Encore une fois, que des hydrates ou des gaz d’aquifères soient extractibles un jour reste un objet de débat, car il n’a pas été établi à ce jour qu’il existe des gisements significatifs quelque part [4].

De ce fait, une estimation raisonnable concernant les réserves ultimes restantes (pour le gaz) peut être faite à 350 Gtep, et pas plus de 150 Gtep (environ) ne peuvent être consommées avant le pic de production. Cela élimine 39 scénarios (sur 40) qui supposent plus de 150 Gtep de gaz avant le pic. Les réserves ultimes restantes devaient se monter à 500 Gtep pour obtenir 5 scénarios compatibles pour l’aspect gaz, à 900 Gtep pour obtenir 20 scénarios compatibles, et à près de 3000 Gtep pour que l’ensemble des scénarios soient compatibles avec une consommation décrivant une courbe en cloche.

En d’autres termes, en ce qui concerne le gaz tous les scénarios supposent qu’il y aura une augmentation considérable des réserves ultimes, ce qui signifie que tous les scénarios supposent que des quantités considérables d’hydrates seront exploitables d’ici quelques dizaines d’années. En effet en ce qui concerne les découvertes de gaz conventionnel, les découvertes ont culminé au début des années 1970 et diminuent depuis, ce qui rend peu probable une augmentation soudaine des découvertes aujourd’hui, et, comme le taux d’extraction standard du gaz est déjà de 80% (pour le gaz conventionnel), il n’y a pas grand’chose comme réévaluation à attendre de ce côté-là.

Pour le charbon, les chiffres fréquemment publiés concernant les réserves font état de 500 Gtep (charbon et lignite), mais les ressources en terre sont beaucoup plus importantes, et les chiffres varient de 2800 à 4300 Gtep pour les publications récentes, avec la limitation importante qu’il semblerait qu’un organisme seulement ait fait une estimation des ressources mondiales en charbon [7]. Si nous nous limitons à des considérations d’ordre purement technique, il n’est pas facile de décider d’une limite supérieure pour les réserves additionnelles à partir des ressources. Les techniques qui permettent d’accéder aux ressources en charbon ne se limitent pas à l’extraction : en particulier le charbon profond peut être gazéifié, ce qui transforme une veine de charbon en un genre particulier de gisement de gaz. Au vu des techniques déjà disponibles, et du bilan énergétique net de l’extraction minière ou de la gazéification, qui reste positif dans la majorité des cas, nous ne pouvons exclure qu’une partie très importante des ressources devienne extractible si les prix deviennent suffisamment élevés.

Si nous supposons que les réserves ultimes restantes se montent à 2500 Gtep pour le charbon, alors 35 scénarios sont compatibles avec une consommation en cloche pour la partie charbon. Il apparaît que les estimations publiées par des organisations professionnelles ou des techniciens et les hypothèses des scénarios sont bien plus compatibles en ce qui concerne le charbon qu’en ce qui concerne le pétrole ou le gaz.

Une première conclusion est que si nous considérons que la ventilation entre les différentes combustibles fossiles, dans les scénarios d’émission, est un point essentiel, alors il est assez clair que la quasi-totalité de ces scénarios sont improbables : pour le pétrole et le gaz ils supposent des consommations qui sont pas compatibles avec les estimations publiées par ailleurs en ce qui concerne les réserves ultimes restantes.

Mais nous pouvons aussi ne regarder que l’agrégat de tous les combustibles fossiles, avec l’hypothèse qu’ils peuvent se substituer les uns aux autres : le charbon peut être liquéfié pour obtenir des carburants de synthèse (ce qu’ont fait les allemands pendant la seconde guerre mondiale, ou ce que font les sud-africains), ou peut être gazéifié, et le gaz peut à son tour être transformé en combustibles liquides. Nous pouvons alors refaire l’exercice en considérant que tout ce qui compte est la consommation globale de combustibles fossiles, et « éliminer » les scénarios pour lesquels la consommation de ces combustibles continuerait à croître après que la moitié des réserves ultimes de l’agrégat (charbon + pétrole + gaz) ait été utilisé.

Si nous voulons avoir une idée du haut de la fourchette des possibilités, nous pouvons aussi prendre des valeurs un peu plus élevées pour les réserves ultimes de gaz et de pétrole, tout en gardant des nombres compatibles avec certaines estimations publiées par des instituts techniques, soit 450 Gtep pour chaque combustible (ou plutôt 900 Gtep pour l’ensemble). Si les réserves ultimes de charbon se montent à 2500 Gtep, ce qui nous amène à 3400 Gtep de réserves agrégées pour les combustibles fossiles, alors 15 scénarios présentent une consommation cumulée de ces combustibles avant le pic qui est possible. Le plus émissif de cet ensemble (B2C-MARIA) conduit à des émissions cumulées d’environ 1350 Gtc (sur la base de 1,12 tC/tep pour le charbon, 0,83 tC/tep pour le pétrole et 0,65 tC/tep pour le gaz).

La concentration atmosphérique en CO2 qui en résulterait serait dans les alentours de 800 ppm en 2100, et dépend de ce que serait le recyclage du CO2 vers les océans et les écosystèmes continentaux durant le 21e siècle. Que nous supposions un recyclage constant de 4 tC/an de 2000 à 2100, ou un recyclage proportionnel de 40% des émissions pendant cette période, qui sont deux hypothèses simples – et peut-être simplistes, le résultat est à peu près le même. Si les réserves ultimes de charbon se montent à 4000 Gtep, nous amenant à 4900 Gtep de réserves ultimes agrégées pour les combustibles fossiles, alors 36 scénarios (sur 40) deviennent possibles, avec des concentrations atmosphériques en CO2 qui se trouveraient entre 900 et 1200 ppm en 2100, selon le taux de recyclage du CO2 choisi.

Une conclusion préliminaire de cette brève analyse des scénarios, à la lumière des données diponibles concernant les ressources en combustibles fossiles est que, si nous supposons que les données actuelles donnent le bon ordre de grandeur concernant les réserves ultimes, les scénarios les « plus extrêmes » (comme A1C-AIM ou A1FI-MiniCam) ne semblent pas très plausibles (pour la partie combustibles fossiles), même si ils ne peuvent pas être déclarés complètement impossibles. Pour autant, la partie haute de ce qui n’est pas impossible au vu des données connues sur les occurrences de combustibles fossiles dans le sous-sol, à savoir plus ou moins 1000 ppm, reste très inquiétant. L’augmentation de la concentration atmosphérique en CO2 qui va avec le haut de la fourchette des scénarios plausibles est encore suffisante pour conduire à un changement climatique majeur, avec quelques degrés d’élévation de la température en un siècle pour commencer.

Il apparaît donc que la menace de court terme d’une pénurie de pétrole conventionnel, lequel représente environ 40% de l’approvisionnement énergétique mondial aujourd’hui, laquelle pénurie pourrait assurément conduire à des soubresauts majeurs du système socio-économique, n’est pas exclusive de troubles majeurs liés au changement climatique à plus long terme, si après que le pétrole et le gaz aient passé leur pic de production l’humanité se tourne progressivement mais massivement vers le charbon. En pareil cas, la séquestration des émissions de CO2 ne concernerait pas les sources diffuses (petite industrie, transports, chauffage) et le taux de diffusion pour les sources intensives reste un objet de débat, sachant qu’aujourd’hui il n’y a que quelques prototypes en fonctionnement.

1.3 Energie nucléaire

Les scénarios d’émission ont également une contribution du nucléaire à l’approvisionnement énergétique mondial. Bien que le recours à l’énergie nucléaire n’ait pas d’effet direct sur les émissions de gaz à effet de serre, cela a un effet indirect, car cela permet d’avoir une croissance économique plus importante sans recourir autant aux combustibles fossiles (parce que l’énergie globale consacrée aux activités productives augmente sans augmentation des émissions). Les tables statistiques de [2] donnent la quantité « d’énergie primaire » provenant de l’énergie nucléaire pour les divers scénarios. Il n’est pas précisé si la contribution désigne la production électrique ou l’énergie primaire (thermique), c’est-à-dire l’énergie thermique créée à l’intérieur du réacteur (qui est actuellement de l’ordre de trois fois la production électrique). Nous avons supposé que les valeurs données concernaient la production électrique, parce que c’est l’usage le plus courant, et calculé le nombre de réacteurs que cela requiert de produire cette électricité, en supposant qu’un réacteur fonctionne 7500 heures par an (sur un total de 8.760), et a une puissance électrique nominale de 1400 MW.

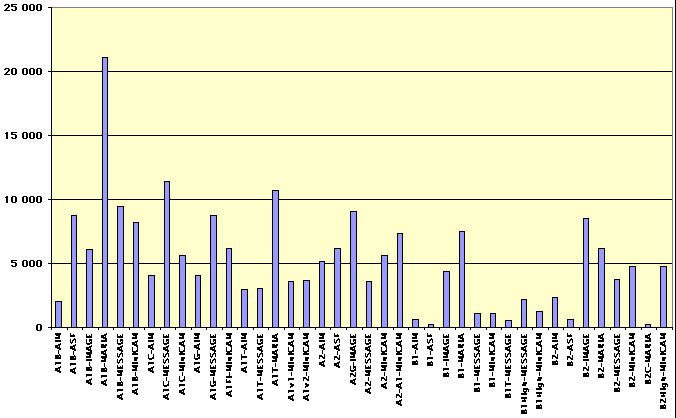

Le nombre de réacteurs fonctionnant en 2100 pour les divers scénarios figurent sur le graphique ci-dessous (à titre de comparaison, le monde possède aujourd’hui 450 réacteurs environ, mais 40.000 barrages de plus de 15 mètres de chute, les productions mondiales du nucléaire et de l’hydroélectricité étant équivalentes).

Nombre de réacteurs nucléaires en 2100 pour les 40 scénarios du SRES.

Une centrale possède généralement 4 réacteurs.

Si les valeurs données sont à prendre comme « énergie primaire » et non « production électrique », les résultats ci-dessus sont à diviser par 3. Quelle que soit l’hypothèse retenue, les scénarios qui envisagent un nombre de réacteurs dépassant quelques milliers supposent que les surgénérateurs vont se répandre, parce que mettre en service un tel nombre de réacteurs avec la seule fission de U235 n’est pas possible au vu des quantités récupérables d’U235 sur terre, même avec des prix de minerai fortement augmentés.

Les réserves ultimes en uranium 235 sont estimées à 6 millions de tonnes [5], soit un peu plus de 500 Gtep. Ce nombre ne tient pas compte de l’uranium présent dans l’océan, mais le taux de dilution dans l’eau de mer est tel que d’obtenir un flux significatif d’U235 de l’océan reste spéculatif aujourd’hui. Un réacteur de 1400 MW utilise 2,7 Mtep d’uranium par an (énergie primaire), ce qui signifie qu’avec 4.000 réacteurs, toutes les réserves d’U235 sont consommées en 50 ans, ce qui amène à la conclusion ci-dessus sur les surgénérateurs : avec des réacteurs de ce type; les réserves ultimes en uranium permettraient environ 2500 ans de fonctionnement pour plusieurs milliers de réacteurs.

1.4 biomasse

Les scénarios comprennent aussi une contribution de la biomasse. Le même genre de remarque préliminaire que pour le nucléaire peut être faite : la biomasse renouvelable ne contribue pas directement à augmenter la concentration atmosphérique de CO2. Elle a, cependant, un effet direct sur les émissions d’aérosols, et un effet indirect sur la concentration en ozone troposphérique (l’ozone est un gaz à effet de serre), et donc sur le bilan radiatif de l’atmosphère. Elle a aussi un effet indirect sur la consommation de combustibles fossiles. Enfin toute la biomasse actuellement utilisée n’est pas renouvelable, parce qu’une partie provient de la déforestation, de telle sorte que l’utilisation de la biomasse a un effet sur le changement d’usage des sols, qui contribue directement aux émissions de CO2.

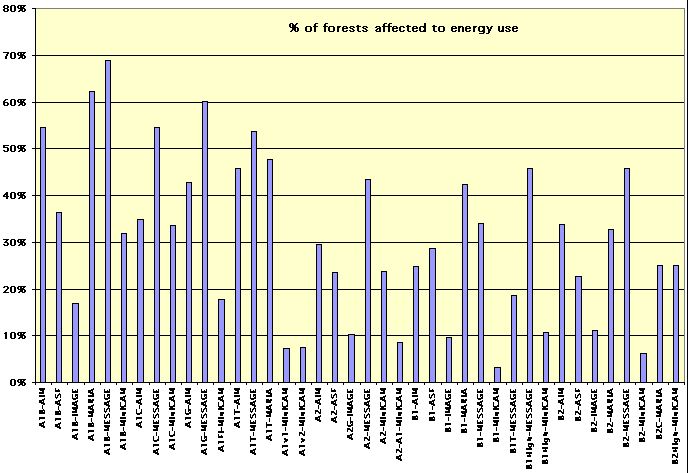

Avec quelques hypothèses simples, nous pouvons calculer la proportion des terres émergées qui doit être consacrée à l’obtention de biomasse renouvelable pour chacun des 40 scénarios. Tout d’abord nous avons supposé une productivité primaire des écosystèmes gérés de 7 tonnes de matière sèche par hectare et par an. La plupart des forêts exploitées sur terre ont des productivités primaires allant de 4 à 10 tonnes de matière sèche par hectare et par an [6] [9]. Rappelons au lecteur que si la biomasse subit un quelconque procédé de transformation avant d’être utilisée (ce qui est le cas des biocarburants), seule la production nette par hectare doit être prise en compte, après que les consommations intermédiaires (fabrication des engrais, utilisation des engins agricoles, distillation, etc) aient été déduites.

Nous avons aussi supposé que le contenu énergétique de la biomasse est de 0,5 tep par tonne de matière sèche, ce qui donne une productivité primaire de 3,5 tep par hectare en moyenne pour le monde entier. Les résultats du graphique ci-dessous sont donnés en pourcentage de la superficie forestière actuelle qui devrait être consacrée à la production d’énergie à partir de biomasse en 2100, et il faut garder en mémoire – pour faire des comparaisons – que les forêts occupent actuellement de l’ordre de 30% des terres émergées. Il faut aussi garder en mémoire que la croissance démographique exerce une pression à la baisse pour cette surface. Cette pression à la baisse devrait logiquement augmenter quand les scénarios envisagent une multiplication par 1,5 à 2,5 de la population actuelle.

Pourcentage de la surface forestière actuelle consacrée à l’obtention d’énergie en 2100 pour les divers scénarios, avec les hypothèses décrites ci-dessus.

Il apparaît que certains scénarios du groupe A1 sont assurément très « extrêmes », supposant que la moitié des forêts actuelles – ou une surface équivalente – soit consacrée à l’obtention d’énergie. L’auteur n’a pas de limite objective à proposer en ce qui concerne la fraction des forêts actuelles qui peut raisonnablement être utilisée pour l’obtention d’énergie, mais néanmoins ces résultats semblent très (trop ?) élevés, surtout avec une population en croissance comme il est supposé dans les scénarios.

1.5 Conclusion préliminaire

Cet examen rapide des scénarios d’émission conduit à la conclusion préliminaire que la partie haute de la fourchette est vraisemblablement très improbable, bien que l’on ne puise pas l’éliminer comme absolument impossible. L’aspect improbable des scénarios extrêmes ne doit pas conduire à écarter le risque de changement climatique, sachant que des « scénarios moyens modifiés », avec une consommation d’énergie ou une population qui n’augmenteraient pas aussi vite que supposé, mais avec un recours massif au charbon après que le pétrole devienne cher, représente encore une menace significative pour l’avenir, en ce sens que cela conduit encore à quelques degrés d’augmentation dans les simulations connues [1]. En outre, il convient de se rappeler que les élévations de température mentionnées dans le rapport d’évaluation de 2001 du GIEC ne prend pas en compte des rétroactions potentiellement puissantes, qui pourraient engendrer une accélération temporaire d’un changement climatique initial résultant du seul effet des émissions des activités humaines :

- l’action en retour du cycle du carbone, qui pourrait ajouter de un à plusieurs degrés à la fin du 21e siècle avec un scénario « moyen-haut » concernant les émissions d’origine humaine, qui reste dans les limites du « raisonnable » évalué ici [1] [7],

- la fonte possible d’une partie du pergélisol [1], qui pourrait alors transformer une partie de la toundra boréale en gigantesques marécages qui deviendraient des sources de méthane, ou qui pourraient larguer des quantités importantes – mais impossibles à évaluer aujourd’hui – de méthane auparavant emprisonné sous le pergélisol.

Si cela était possible, il serait idéal de coupler les modèles de climat avec des modèles de scénarios d’émission, ces derniers étant eux-mêmes couplés aux estimations de réserves ultimes. Un tel couplage permettrait probablement une coopération intéressante entre les scientifiques du climat et les ingénieurs de l’énergie.

2 – Diminution des émissions : jusqu’où devrions nous aller ?

Nous pouvons maintenant nous pencher sur l’autre extrémité de la fourchette des évolutions possibles, bien qu’aucun scénario d’émission ne corresponde à cet objectif, qui représente ce que nous devrions faire pour arrêter d’augmenter la quantité de gaz à effet de serre dans l’atmosphère. Le reste de l’article ne concerne que le cas du CO2.

Pour arrêter d’enrichir l’atmosphère en dioxyde de carbone, le principe est très simple : les émissions d’origine humaine doivent rester en-dessous du recyclage par les « puits de carbone » (les océans pour une partie, les écosystèmes continentaux pour le reste). Mais ce recyclage n’est pas constant avec le temps, et suit quelques règles simples :

- pour la partie continentale, il augmente avec la concentration atmosphérique de CO2 : une atmosphère qui contient plus de CO2 favorise, dans un premier temps (c’est-à-dire avant que toute modification majeure du climat ne survienne), la productivité primaire des écosystèmes en place,

- pour la partie océanique, le recyclage augmente aussi avec la concentration atmosphérique de CO2 : la quantité de CO2 qui se dissout dans l’eau de mer augmente si l’air contient plus de CO2 (les pressions partielles de CO2 dans l’air et dans l’eau s’équilibrent : si elle augmente dans l’air, elle augmente aussi dans l’océan),

- mais, pour les puits continentaux comme pour l’océan, l’absorption décroît avec la température : l’eau océanique dissout moins de CO2 quand elle tiédit, et dans un climat qui se réchauffe l’augmentation de productivité des écosystèmes (si elle subsiste) compense de moins en moins une décomposition accélérée des débris organiques du sol, qui remet du CO2 dans l’atmosphère [1].

La conséquence de ce dernier effet est qu’un niveau donné d’émissions de CO2, qui permet d’avoir une stabilisation instantanée de la concentration en CO2 à un moment donné, deviendra excessif plus tard pour conserver une concentration en CO2 constante, parce que le recyclage aura faibli avec l’élévation de température, pendant que les émissions seront restées les mêmes. De la sorte, le « bon niveau » sous lequel nous devrions rester en ce qui concerne les émissions de CO2, car il permet d’obtenir la stabilisation, évolue – et décroît – avec le temps.

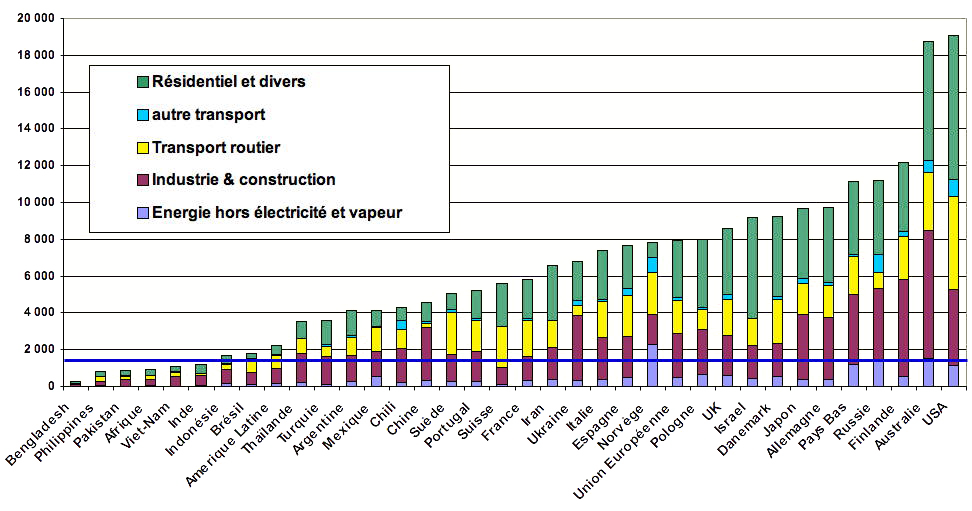

Pour la discussion qui suit nous allons prendre une approximation au premier ordre, qui permet en fait de fixer une limite supérieure aux émissions. Aujourd’hui, les émissions anthropiques de CO2 représentent à peu près le double du recyclage total (océans et écosystèmes continentaux). De ce fait l’objectif minimum qui a un sens au regard des faits physiques est que le monde doit diviser par deux ses émissions de CO2, ou encore ramener les émissions de CO2 à 3 milliards de tonnes de carbone par an.

Concrètement, qu’est-ce que cela signifie pour vous et moi de n’émettre que 3 Gt d’équivalent carbone par an pour le seul CO2 ? 3 milliards de tonnes de carbone pour 6 milliards d’individus, cela représente, équitablement répartis, 500 kg de carbone par personne et par an, ou encore (en se référant aux données de 1998) :

- moins de 10% des émissions actuelles de CO2 d’un Américain ou d’un Australien (les Américains devraient donc diviser leurs émissions par plus de 10 au titre de leur participation à la stabilisation de la quantité de CO2 dans l’atmosphère),

- Entre 15 et 20% des émissions d’un Allemand ou d’un Danois, qui devraient donc diviser leurs émissions par 6 au titre de leur participation à la stabilisation,

- 20% des émissions d’un Anglais ; les émissions individuelles en Grande Bretagne devraient donc être divisées par 5,

- environ 25% des émissions d’un Français, ou d’un Suisse (ou d’un Suédois), ce qui signifie que que c’est une division par 4 qui est requise ici,

- environ 30% des émissions d’un Portugais, qui devra donc diviser ses émissions par 3,

- environ 50% des émissions d’un Mexicain ; ce pays émet donc déjà 2 fois trop pour une stabilisation volontaire du CO2 dans l’air,

- déjà 60% des émissions d’un Chinois, ce qui signifie ce pays, aussi « pauvre » qu’il puisse être considéré, est déjà 40% trop « riche » en ce qui concerne ses émissions de CO2,

- Mais 120% des émissions d’un Indien, 2 fois celles d’un Pakistanais, ou encore 20 fois celles d’un Népalais : quelques pays ont donc encore la possibilité d’émettre un peu plus….

Comparaison entre les émissions brutes de CO2 par habitant en 2004 (CO2 seul, sans les puits) et « l’allocation maximale » 500 kg équivalent carbone par personne et par an, (trait horizontal bleu foncé).

Cette allocation maximale représente l’objectif si nous voulons diviser les émissions mondiales de CO2 par deux avec 6 milliards d’hommes sur terre.

Avec les technologies actuellement en usage, ce « droit maximal à émettre sans perturber le climat » (de 500 kg d’équivalent carbone de CO2), est atteint dès que nous avons fait une seule des choses suivantes :

- fait un aller-retour de Paris à New York en avion,

- consommé 3.200 kWh d’électricité en Grande Bretagne (ou 3.000 kWh aux USA), mais 22.000 kWh en France ou en Suisse, à cause de la quantité d’électricité « sans carbone » dans ces pays, sachant que la consommation annuelle par Français est de l’ordre de 6700 kWh actuellement (dont plus de 50% nous est « invisible », parce qu’il s’agit d’électricité « contenue » dans les divers produits de l’industrie ou de l’agriculture que nous achèterons ensuite).

- acheté 50 à 500 kg de produits manufacturés (soit au plus le tiers d’une petite voiture, moins s’il y a beaucoup d’électronique ou de matériaux rares).

- acheté 1,5 micro-ordinateur à écran plat,

- utilisé 2 tonnes de ciment (une maison moderne de 100 m² en nécessite 10),

- conduit un peu plus de 5.000 km en zone urbaine en petite voiture, soit 6 mois de circulation en moyenne en Île de France,

- conduit, toujours en zone urbaine, seulement 1.500 km en gros 4×4 ou en Mercédès ou avec tout autre aspirateur à essence identique,

- consommé 1.000 m³ de gaz naturel (soit quelques mois de chauffage d’une maison).

Ces valeurs sont issues de [8].

Certains lecteurs peuvent penser que, vu ce que cela signifie de parvenir à une stabilisation volontaire, celle-ci n’arrivera jamais : bien que l’essentiel de ce qui est listé ci-dessus ait moins de 50 ans, certains considéreront que de faire sans – ou avec beaucoup moins – signifie retourner à l’âge de pierre. L’auteur aimerait souligner que, dans un monde fini, l’alternative à une absence de stabilisation volontaire n’est pas une augmentation indéfinie, mais juste une stabilisation qui se produira sans nous demander notre avis, à travers des effets en retour (des rétroactions) qu’il se pourrait que nous appréciions beaucoup moins que les efforts que nous devrions consentir pour parvenir à une stabilisation volontaire.

En effet, le fait que les émissions doivent être égales à l’absorption « un jour » n’est pas négociable, parce que la concentration atmosphérique en CO2 ne peut pas augmenter indéfiniment. En outre, le montant global de combustibles fossiles est limité, et la superficie des forêts que nous pouvons défricher l’est aussi. Comme les émissions cumulées provenant des combustibles fossiles et du changement d’usage des sols ont une limite supérieure, il est alors mathématiquement certain que les émissions d’origine humaine ne peuvent que tendre vers zéro – en moyenne – avec le temps, et donc il est certain que « un jour » les émissions mondiales passeront sous la moitié de ce qu’elles sont aujourd’hui.

La seule bonne question est la suivante : choisissons nous de diminuer volontairement les émissions de gaz à effet de serre, ou est-ce que nous essayons de suivre le chemin d’émissions croissantes aussi longtemps que possible, en attendant que ce soient des événements non désirés qui se chargent d’engendrer cette baisse « plus tard », acceptant implicitement, alors, que cela arrive dans des conditions que nous pourrions ne pas contrôler, et qui pourraient être très désagréables ?

Références

[1] Houghton et al., Climate Change 2001, The Scientific basis, Cambridge University Press, 2001

[2] Nakinovic et al., Emissions Scenarios, A special report of WGIII of the Intergovernmental Panel on Climate Change, Cambridge University Press, 2000

[3] ASPO Second international workshop on oil & gas, Paris, May 26-27 2003

[4] Jean Laherrere, Estimates of Oil Reserves, Paper presented at the EMF/IEA/IEW meeting, IIASA, Laxenburg, Austria – June 19, 2001

[5] Reserves, Resources and Availability of Energy Resources 2002, Federal Institute for Geosciences and Natural Resources, Hannover

[6] Watson et al, IPCC Special Report on Land Use, Land-Use Change And Forestry, Cambridge University Press, 2000

[7] Dufresne, J.L., Friedlingstein, P., Berthelot, M., Bopp, L., Ciais, P., Fairhead, L., Le Treut, H. & Monfray, P., 2002. On the magnitude of the positive feedback between future climate change and the carbone cycle. Geophysical Research Letters, 29(10).

[8] Jancovici, JM, Bilan Carbone d’une activité manufacturière ou tertiaire, méthodologie, Ademe, 2001-2004

[9] Good Practice Guidance for Land Use, Land-Use Change and Forestry, IPCC National Greenhouse Gas Inventories Programme, in press

[10] Bauquis, PR, What future for extra-heavy oil and bitumen : the Orenoco case, 17th World energy Congress, Huston, Sept. 1998

[11] Bauquis, PR, A reapraisal of energy supply and demand in 2050, Oil & Gas Science and Technology (revue de l’Institut Français du Pétrole), vol. 56 N° 4, pp 389 – 402, 2001